-

开课时间

2024.06.27 19:55

-

课程时长

44分钟

-

学习人数

2249人次学习

- 课程介绍

- 精华文稿

- 课件领取

- 相关课程

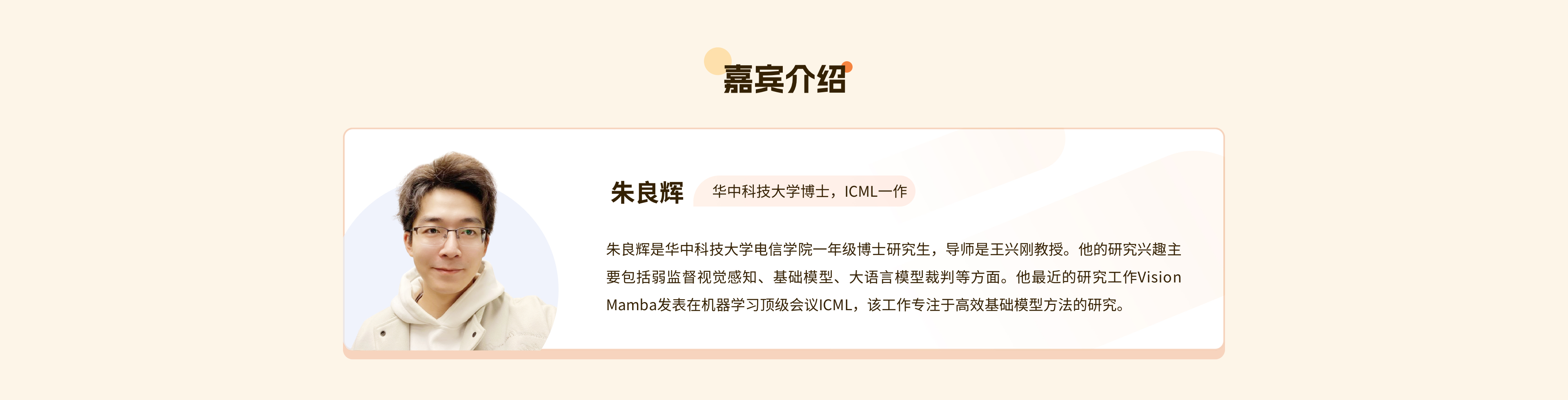

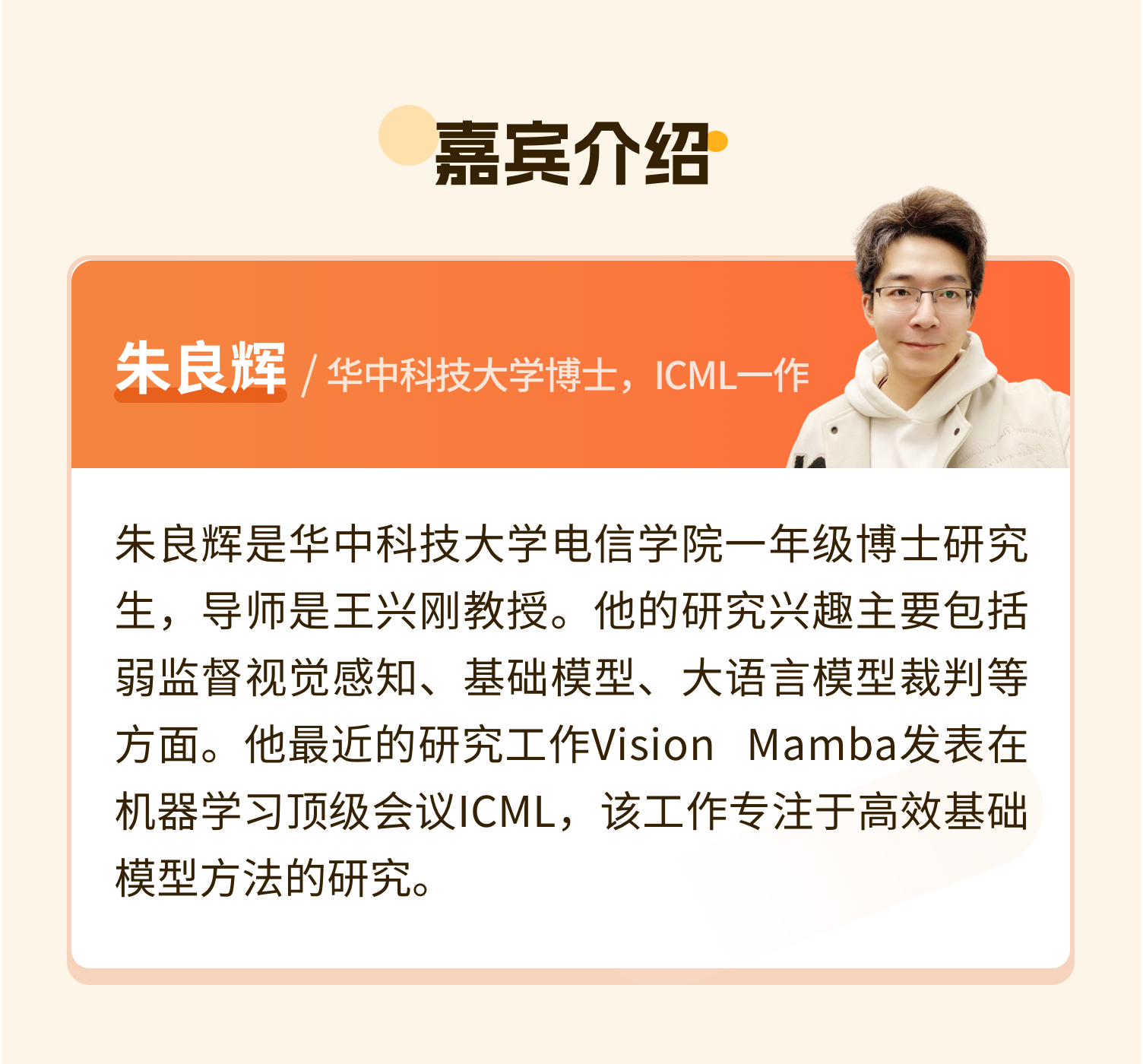

Transformer 凭借着其出色的全局建模能力逐渐风靡各大人工智能的细分领域。然而,二次方的建模复杂度限制了我们更进一步在长序列的文本、图像上对其进行应用。近年来,次二次方复杂度的建模网络如 Mamba、GLA、RWKV 等逐渐出现在了大众的视野中。这些方法能够以接近线性的复杂度来处理各种不同的序列建模问题,这也同样吸引着我们去探索将之应用在视觉任务上的可能性。然而,视觉任务不同于文本、语音等一维序列建模任务,其独特的空间关系也是不可忽视的一点。Vision Mamba正是为了解决此类问题而进行的一次探索,本次分享我们将一起探索 Mamba 应用到视觉任务的种种关键所在,并讨论其在视觉任务中的潜力以及更广大的应用方向。

具有高效硬件感知设计的状态空间模型(SSMs),即Mamba,已经展现出对于长序列建模的巨大潜力。仅基于SSMs构建高效且通用的视觉骨干是一种吸引人的方向。然而,由于视觉数据的位置敏感性和对于全局上下文的要求,对于SSMs来说,表示视觉数据是具有挑战性的。在本文中,我们展示了视觉表示学习依赖于自注意力的观点是不必要的,并提出了一种新的具有双向Mamba块(Vim)的通用视觉骨干,它使用位置嵌入标记图像序列,并使用双向状态空间模型压缩视觉表示。在ImageNet分类、COCO目标检测和ADE20k语义分割任务中,与DeiT等成熟的视觉转换器相比,Vim实现了更高的性能,同时还展示了显着的计算和内存效率改进。例如,在执行分辨率为1248×1248的图像的批量推理以提取特征时,Vim比DeiT快2.8倍,并节省86.8%的GPU内存。结果表明,Vim能够克服计算和内存约束,实现对于高分辨率图像的Transformer-style理解,并且具有成为视觉基础模型下一代骨干的巨大潜力。代码可在https://github.com/hustvl/Vim获得。